好书推荐 | 《人工智能:重塑秩序的力量》

本文摘要:(由ai生成)

本文概述了AI的发展历程、挑战与前景。AI已广泛应用于多领域,但面临诸多挑战。未来,需深入研究、关注社会影响及加强数据保护。GPT等大模型展现出强大能力,并探索了AI在艺术创作上的可能性。最后,推荐了一本全面介绍AI的图书,帮助读者深入了解AI发展全貌。人工智能(AI)的概念最早可以追溯到20世纪50年代,当时科学家们开始探索如何让计算机模拟人类的思维过程。随着计算机技术的发展,AI研究逐渐从理论走向实践。20世纪80年代,专家系统和机器学习等技术的出现,使得AI开始在特定领域得到应用。进入21世纪,随着大数据、云计算和深度学习等技术的突破,AI得到了飞速发展,应用领域也从最初的棋类游戏、语音识别扩展到自动驾驶、医疗诊断、金融风控等多个领域。

尽管AI取得了显著的进展,但在学术、产业和技术方面仍面临诸多争议和挑战。学术上,AI的发展引发了关于意识、自由意志和道德责任等方面的哲学讨论。产业上,AI技术的广泛应用可能导致劳动力市场的结构性变革,部分岗位可能被取代。技术上,AI面临的挑战包括算法的可解释性、数据隐私和安全等问题。此外,AI技术在军事、监控等领域的应用也引发了伦理和人权方面的争议。

未来,AI将继续发展壮大,但需要解决的挑战和困境也将更加复杂。学术界需要继续深入研究AI的基本理论,提高算法的可解释性和泛化能力。产业界需要在推动AI技术应用的同时,关注其对劳动力市场、社会公平和环境的影响。技术层面,需要加强数据隐私保护和安全防护措施,确保AI技术的可持续发展。同时,政府、企业和公众应共同参与,制定合理的政策和规范,引导AI技术的健康发展,以实现人类与AI的和谐共生。

2022年,GPT和LLM横空出世,它们对人们的生活产生了深远的影响。例如,GPT可以用于智能客服、语音助手等场景,提高人们的工作效率;而LLM则可以用于文本生成、机器翻译等领域,为人们提供更加便捷的服务。我们挑选了一下几个问题给LLM之一——星火大模型回答。

Q1

如何理解算法、数据和算力及其相关关系?

算法、数据和算力是人工智能发展的三大核心要素,它们之间存在密切的相关关系。具体分析如下:

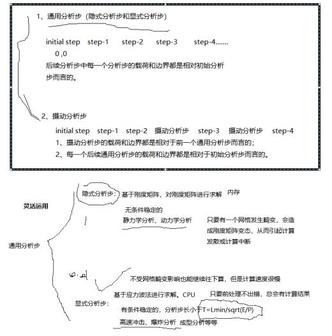

1. 算法:算法是人工智能的灵魂,它决定了AI的智力水平。算法可以理解为一系列解决问题的步骤和规则,它是处理数据、提取信息、做出决策的核心。算法的好坏直接影响到AI的学习能力和智能表现。例如,深度学习算法能够通过大量数据训练,识别图像、语音等复杂模式。

2. 数据:数据是人工智能的食粮,它是AI学习和进步的基础。没有数据,AI就无法学习知识和提升能力。在机器学习和深度学习中,大量的高质量数据是必不可少的。数据的数量和质量直接关系到AI模型的训练效果和泛化能力。

3. 算力:算力是人工智能的动力,它决定了AI处理问题的速度和效率。算力可以理解为计算资源,包括CPU、GPU等硬件设备。随着AI模型变得越来越复杂,对算力的需求也越来越高。没有足够的算力,即使有优秀的算法和大量的数据,AI的训练和推理过程也会变得极其缓慢,甚至无法完成。

4. 相关关系:这三者相互依赖、相互促进。算法需要数据来训练和优化,数据的收集和处理又需要算力的支持。同时,随着算法的进步,对数据处理能力和计算速度的要求也会提高,从而推动算力的发展。反之,算力的提升和数据的增长也能促进更复杂、更高效算法的产生。

总之,算法、数据和算力共同构成了人工智能发展的基础,它们的相互作用推动了AI技术的进步和应用的普及。在未来,这三个要素的协同发展将继续引领人工智能向更高层次的智能迈进。

Q2

如何改进人工智能算法可以既得到好的结果,又能减少算力和显卡的消耗?

改进人工智能算法以获得好的结果同时减少算力和显卡消耗,可以从以下几个方面入手:

1. 模型简化:精简模型结构,去除不必要的层或节点,使用更小的网络。例如,采用MobileNets、SqueezeNet等为移动设备设计的轻量级神经网络。

2. 参数共享与迁移学习:利用预训练模型进行迁移学习,只在必要的层次上调整权重,这样可以减少训练所需的计算量。

3. 量化与二值化:对模型的权重和激活进行量化,减少数值表示的精度,如使用二值化网络(BNNs),可以显著减少所需的计算资源。

4. 知识蒸馏:将大型、复杂模型的知识转移到小型、高效的模型中,通过这种方法,小型模型可以达到接近大型模型的性能。

5. 稀疏性优化:在训练过程中鼓励模型权重矩阵的稀疏性,这样可以减少存储和计算的需求。

6. 模型剪枝:通过移除模型中不重要的权重或神经元来减小模型的大小,这通常对最终性能影响不大。

7. 数据压缩和选择性训练:对数据集进行压缩或选择性地使用子集进行训练,可以减少数据加载和处理的时间。

8. 并行计算与硬件优化:优化算法以更好地利用GPU或其他专用硬件的并行处理能力。

9. 使用云服务和分布式计算:虽然这可能不会直接减少算力消耗,但可以通过云服务按需分配计算资源,从而降低成本。

10. 算法效率改进:研究和实现更高效的优化算法、正则化技术和损失函数,以提高收敛速度和减少过拟合。

11. 自适应学习率和早期停止:使用自适应学习率可以在保持收敛速度的同时减少不必要的迭代,而早期停止可以在验证性能不再提升时终止训练,节省计算资源。

12. 混合精度训练:使用不同精度的浮点数进行训练,如结合使用单精度和半精度浮点数,可以在不影响结果质量的前提下减少内存使用和提高计算速度。

通过这些方法,可以在保持或甚至提高模型性能的同时,减少对算力和显卡资源的消耗。然而,这些方法的应用需要根据具体问题和可用资源进行权衡和选择。

Q3

请按照李白,杜甫的写诗风格分别以梅花为主题写一首七言绝句。

李白风格:

梅香独自傲霜雪,

月下风中舞剑歌。

千树万枝皆白首,

独留青眼看江山。

杜甫风格:

梅花独立寒枝上,

雪后初晴影斜阳。

世事如烟人易老,

只有清香似故乡。

我们看到,大模型给出的回答某些时候甚至比人的回答更好。关于大语言模型,事实是:ChatGPT 是基于深度神经网络模型实现的,模型训练使用监督学习和强化学习算法;海量的互联网文本被用作训练语料。ChatGPT 使用的数据量是惊人的。它的前身 GPT-3 模型用 45 万亿字节的数据训练出 1750 亿个参数的神经网络模型,而 ChatGPT 的规模比 GPT-3 的庞大许多。这让人们再次把目光聚焦在算法、数据和算力上。

本书融合了哲学、科学、技术、人文等多个视角,将人工智能发展的全景呈现出来,深入浅出。

精彩样章