数字孪生:可计算的影像医学宇宙

本文摘要:(由ai生成)

本文探讨了数字孪生体技术在医学影像学特别是CT成像领域的应用与挑战。文章回顾了数字孪生技术的背景,分析了医学影像学面临的现实困境,并从可计算性角度思考世界运行范式。文章指出,尽管面临技术和标准挑战,基于可计算性原理的技术应用将为医学影像学带来革命性变化。作者对数字孪生技术在医学影像领域的应用持乐观态度,并期待其未来发挥更大作用。

致力于数字孪生体技术的研究与发展

通过解决方案和工程化应用造福人类

来源:XI区

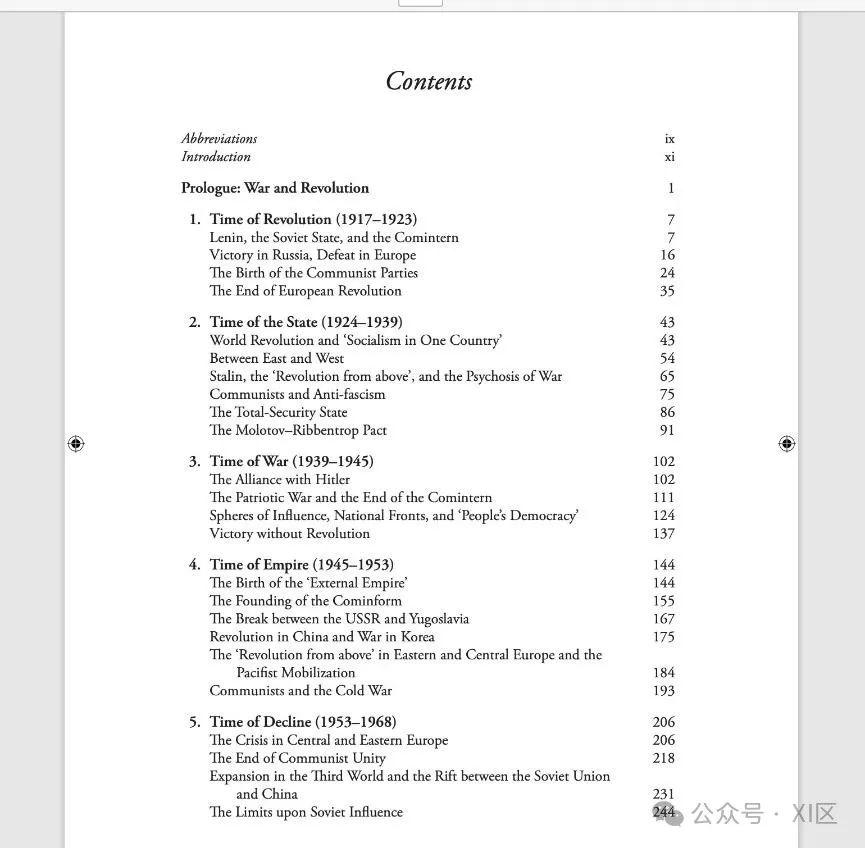

本文全文1.4万字,为了方便阅读,先奉上目录,这样您可以对文章结构有一个大致的了解,随后再享受全文:

一、 不以物喜不以己悲!

a)道之所在,虽千万人吾往矣。

b)古人不见今时月,今月曾经照古人。

c)2003-Digital twin/数字孪生的前世今生。

1)2012-影像组学(Radiomics)

2)2013-蓝脑计划(Blue Brain Project)

3)1985-基因组计划(Human Genome Project, HGP)

4)1994-蛋白质组学计划(proteomics)

d)东方哲学的思维范式真的缺少精确量化概念吗?

二、医学影像学-CT成像的现实困境

a)理想线性CT模型

b)笔形束

1)锥形束

2)线束展平与插值算法

c)单能量

1)物理值定义

2)mono HU

d)散射

1)滤线栅形状与病人位置的影响

2)混合能量射线与能量积分探测器

3)离散采样的影响

4)其他考虑

5)现实CT系统的空间分辨率特性

e)FBP

1)硬件的平衡

2)算法的取舍

f)不可消除的噪声与无法定义的不确定性

1)电子噪声与量子噪声

2)信息学不确定性

g)贝叶斯派和频率派

三、从可计算性看世界的运行范式?

a)他们在创造大脑

1)Alpha go/人类规则,神之一手

2)Alpha fold/自然规则,预测中心法则

3)ChatGPT/超级对齐

1.等价转译

2.通天塔的隐喻

b)哲学之问-计算为什么能取得如此成功?

1)休谟-怀疑主义

2)康德-因果关系是否具有普遍性和客观性?

3)牛顿,爱因斯坦,冯诺依曼-数理逻辑的里程碑!

4)东方文化哲学-道可道,非常道。

c)可计算的宇宙

1)什么是计算?

2)哥德尔不完备定理

3)奥卡姆剃刀

4)可计算性与医学影像的未来

5)神女应无恙,当惊天下殊

以下为正文,医学影像的宇宙已经开启,有兴趣的同志可以留言一起激荡未来。

一、不以物喜不以己悲[i]!

在东方的语境中,道,是一个极其简洁又深刻的概念。道是什么?难以回答,但是我们的文化对志于道而困囿于时代的失败者有着极高的评价。如天子庶民统一法度[iii]的商鞅;志于中兴强国的王安石;工与谋国,拙于谋身的大明首辅张居正;甚至是支持戊戌变法的光绪皇帝。他们的功绩,跨越千年,即使到今日,依旧获得了时代的共鸣。

明月在以光年为计量单位的天文学上作为一颗卫星,可以轻易穿越数千年的岁月,被不同时空中的观察者感叹。那么那些至今激荡的思想是如何跨越千年的?

文字的力量是充满韧性和惊人的,她不仅可以将千百年前的风骨带到现代;亦可以把烽火连三月,家书抵万金的庶民悲欢感同身受。

在我们的行业,我们的文字便是黑白像素构成的宇宙。DICOM 是Digital Imaging and Communications in Medicine的英文缩写,即医学数字成像和通信标准。是ACR(American College of Radiology,美国放射学会)和NEMA(National Electrical Manufactorers Association,国家电子制造商协会)为主制定的用于数字化医学影像传送、显示与存储的标准。

尽管,医学图像不会说话,但是无疑,她见证了目前为止人类最多的悲欢离合和诚挚祈祷。跨越无尽的像素和灰阶,她是否有想告诉人类的信息?

文字是人类思想的映射,医学影像则是人体扫描仪获得的对人体的数字映射,在2023年末的全球科学巨大进展中,以数据驱动的深度学习大模型高歌猛进,使得绝大多数医学影像行业从业者相信。这样的成功将会出现在医疗行业。实际上,对于这种物理和数字空间的映射关系的研究起源于工业界的产品生命周期管理(Product Lifecycle Management (PLM))。

The concept of the Digital Twin[iv]dates back to a University of Michigan presentation to industry in 2002 for the formation of a Product Lifecycle Management (PLM) center. The presentation slide, as shown in Fig was simply called “Conceptual Ideal for PLM.” However, it did have all the elements of the Digital Twin: real space, virtual space, the link for data flow from real space to virtual space, the link for information flow from virtual space to real space and virtual sub-space。

由于这个概念太过重要,因此有必要完整引用这个概念的原文。构成完整数字孪生的条件有:真实的物理世界;虚拟的数字映射;物理世界映射到虚拟世界的数据流;以及最重要的虚拟世界反馈到真实世界的信息流。四个条件缺一不可。

人们习惯于期许文明能带来一个图景清晰的未来,但是正如发明了时钟和历法并不能保证预想的相见;发明了数值天气预报[v]并不能保证明媚的阳光。科学是允许证伪的,基于数值计算理念的科学方法能给医学影像领域带来什么样的未来呢?

1)2012-影像组学(Radiomics)

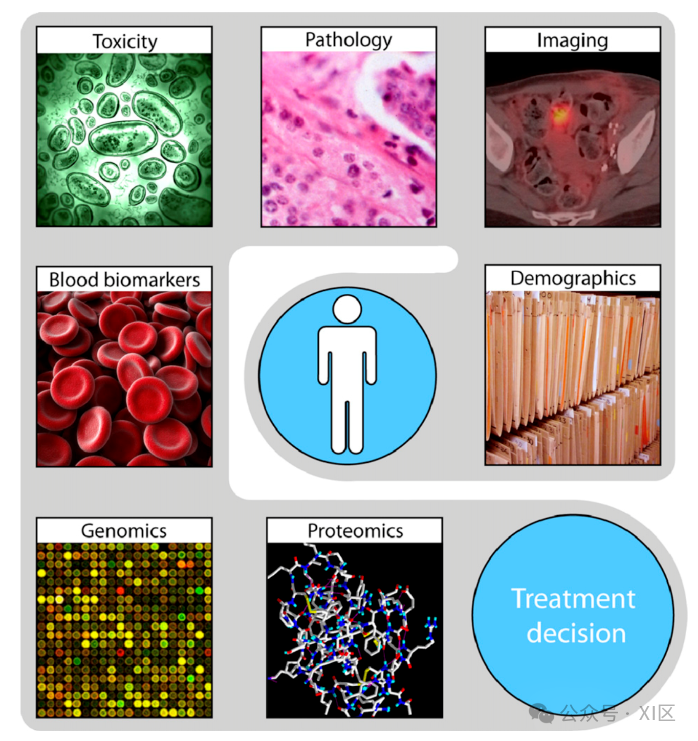

影像组学起源于2012年,由荷兰科学家Philippe Lambin[vi]等首次提出。放射组学是指通过对医学影像进行高通量的特征分析,提取更多的信息。这些特征可以包括影像的强度分布、空间关系、纹理异质性、形状等。通过对这些特征进行分析,可以预测治疗反应和预后,并与基因表达等相关联。放射组学的假设是,通过对医学影像进行定量分析,可以揭示基因和蛋白质表达的宏观影像特征,从而推断表型或基因-蛋白质签名,并可能包含预后信息。放射组学的研究需要进行多中心验证和实验室验证,以进一步验证其有效性。

放射组学的发展历史可以追溯到20世纪90年代末和21世纪初。最初,放射组学主要集中在医学影像的定量分析和特征提取方面。随着计算机技术和图像处理算法的进步,研究人员开始利用大规模的特征分析来提取更多的信息,并将其与治疗反应和预后等临床结果相关联。

放射组学的概念在近年来得到了广泛的关注和研究。越来越多的研究表明,通过对医学影像进行定量分析,可以揭示基因和蛋白质表达的宏观影像特征,从而推断表型或基因-蛋白质签名,并可能包含预后信息。

放射组学的发展受益于医学影像技术的不断进步,包括高分辨率的CT扫描、PET扫描和MRI扫描等。同时,计算机科学和机器学习的发展也为放射组学的研究提供了强大的工具和方法。

总的来说,放射组学的发展历史可以看作是医学影像技术、计算机科学和生物医学研究的交叉融合,为临床医学提供了更多的信息和预测能力。其主要依靠的指标为:图像纹理。

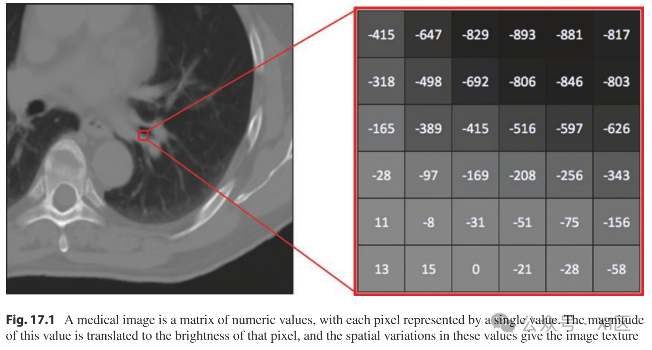

图像纹理/Image Texture ,纹理是指图像中像素值(“亮度”)的局部空间变化。作为图像基础的二维数组中的值可以被描述为该数据的三维表面表示中的高程。因此,纹理可以解释为该表面的“粗糙度”。在许多情况下,粗糙度可以由人类观察者根据其感知到的视觉印象进行定性描述。例如,图像纹理可以被描述为“精细”、“粗糙”、“有颗粒”或“光滑”。具有“细”纹理的图像区域包含空间频率高的小纹理元素,而具有“粗”纹理的图像区域包含空间频率低的大纹理元素。在胸部CT扫描的放射学报告中可能发现的术语,如“磨玻璃不透明”、“蜂窝状”和“马赛克衰减模式”,传达了对扫描肺部区域内纹理的主观评估;通过放射科医生丰富的知识和经验,将这些纹理的定性评估与其他成像和非成像信息相结合,有助于医疗决策的过程。更客观、定量的方法来表征。

纹理可以通过数学纹理分析来实现。纹理作为一个数学实体,具有幅度、空间频率内容和方向。幅度是特定纹理数量的值,而空间频率含量和方向性则捕捉与之相关的空间分布和方向依赖关系一些纹理量。重要的是,虽然纹理是一个单一的概念,但纹理并不是由一个单一的数学结构来表征的。相反,存在不同的方程族来描述图像纹理的不同元素。一些更常用的纹理分析类型是直方图分析、共现矩阵、傅立叶分析、劳斯纹理分析和分形分析,每一种都值得对它们所基于的概念和从应用它们的图像中提取定量信息所需的计算进行简要总结。

2)2013-蓝脑计划(Blue Brain Project[vii])

可视化DICOM图像中的高维纹理信息,并加以功能学分析。在2013年启动的欧洲蓝脑计划走向了巅峰。

这是几乎只有在科幻电影中看到的场景,人类试图打造一个可视化的接口界面。去观察这个果核中的宇宙。

欧盟人类脑计划(Human Brain Project)人类脑计划(HBP)于2013年10月1日启动,原为“蓝脑计划(Blue Brain Project)”,是欧盟委员会未来和新兴技术的旗舰项目。这是一个基于超级计算机的为期10年的大型科研项目,原本旨在对大脑进行大规模模拟,但受到广泛的质疑。2015年,解散Markram领导的3人执行委员会,由22人的董事会取而代之,并将目的改为建立一个基于信息通信技术的协作科研基础设施,让欧洲各地的研究人员在神经科学、计算和大脑相关医学领域推进知识。该项目目前已宣告失败。

但是探索的火种并未熄灭。

美国脑计划(BRAIN Initiative):奥巴马政府于2013年4月2日宣布“脑计划”(BRAIN Initiative,通过推进创新神经技术进行大脑研究),旨在支持创新技术的开发和应用(譬如大规模神经元电生理信号的记录),以促进对大脑功能的动态理解。

日本脑/思维计划(Brain/MINDS):脑/思维(疾病研究综合神经技术脑图绘制)于2014年6月启动,该项目研究集中在三个领域:对普通狨猴大脑的研究;开发脑图绘制技术;人类脑图谱。

中国脑计划(脑科学与类脑科学研究,Brain Science and Brain-Like Intelligence Technology):目前的布局可用“一体两翼”来概括,即以研究脑认知的神经原理为“主体”,其中又以绘制脑功能联结图谱为重点,而研发脑重大疾病诊治新手段和脑机智能新技术为“两翼”。参考蒲慕明等在2016年Neuron期刊上的介绍文章——China Brain Project: Basic Neuroscience, Brain Diseases, and Brain-Inspired Computing(中文版)。

这是医学影像领域的极致探索,即使创造了亚毫米级别的仿真网络,但是,这个结构本身并未给予期待的智慧反馈:即数字孪生定义中虚拟空闲向物理空间的反馈。蓝脑计划也许给出了一个提示,这个网络需要额外的信息。

3)1985-基因组计划(Human Genome Project, HGP)

人类基因组计划[viii](英语:Human Genome Project, HGP)是一项规模宏大,跨国跨学科的科学探索工程。其宗旨在于测定组成人类染色体(指单倍体)中所包含的30亿个碱基对组成的核苷酸序列,从而绘制人类基因组图谱,并且辨识其载有的基因及其序列,达到破译人类遗传信息的最终目的。

4)1994-蛋白质组学计划(proteomics)

2003年4月,历时13年的“国际人类基因组计划”正式完成。但仅仅测绘出基因组序列,并非这一计划的最终目的,必须对其编码产物———蛋白质组进行系统深入的研究,才能真正实现基因诊断和基因治疗。人类蛋白质组研究成为继人类基因组计划之后生物科技发展的重要课题。

d)东方哲学的思维范式真的缺少精确量化概念吗?

从以上的几个项目来看,西方科学计划提出了几乎所有精确完整的概念,在医学影像领域,几乎100%的里程碑成就和规范都起源于西方科学。这一度让我建立了这样的概念:西方科学的成功就是最终的成功,一个学科成功的基础就是建立精确的概念。

因此,东方哲学中的“道”,我⼀直难以有能说服⾃⼰的理由去接受这个概念。基于需要精确概念的前提,我对我行业内的一个问题作了一些思考。

二、医学影像学-CT成像的现实困境

a)理想线性CT模型

In the illustrated CT system, the x-rays are generated from a parallel array of pencil sources with infinitely small focal spot size and infinitely high-temporal coherence (i.e., monoenergetic). The cylindrical image object has a diameter of D and is placed at the isocenter. The post-object x-ray fluence is uniform due to the use of a beam-flattening bowtie filter. Scattered x-rays that do not travel forwardly are completely rejected. The detector has a uniform response along the ρ axis. Except its finite quantum absorption efficiency, the detector does not introduce any other noise or signal-blurring mechanism. The CT system uses the linear filtered backprojection (FBP) algorithm to perform tomographic reconstruction. Image quality models presented in section “Idealized Linear CT Systems” used these idealized conditions.

无限稠密焦点的平行束X射线源

无限高时间分辨率的单能量射线源

扫描物放在绝对的几何中心

X射线散射被100%反射而不是散射

探测器材质具有绝对均一的响应特性

采用原始的线性反投影算法(FBP)

达到以上的条件,那么恭喜你,我们就获得了“Idealized Linear CT Systems”中理想准确的CT值了,与此同时,我们发现,FBP算法在这个场景下也可以成为“金标准”了。但是显然,这如宇宙中的绝对零度一样,现实中难以触及。

b)笔形束

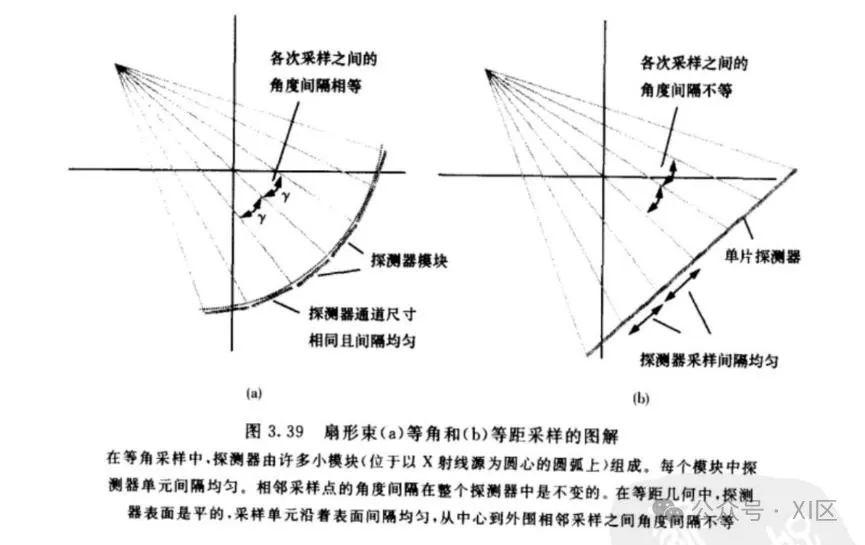

我们已经知道了理想线性CT系统(“Idealized Linear CT Systems”)的定义和要求,知道了物理上的纯净CT值是如何实现的。但是我们知道,在商业实践中,我们无论如何是实现不了无限焦点的平行束和高时间分辨率的单能级X射线源的。其中平行束射线源在实践中常常是Fan beam(扇形束),这是由于目前的球管技术决定的,现代的供应商只能提供单一焦点源的射线源去覆盖探测器。这是一个立体的概念,我们先看看在X-Y平面的影响。

显而易见,无论采用哪种方式去均分探测器单元,在运动的过程中,对扫描物的采样是肯定不均匀的。

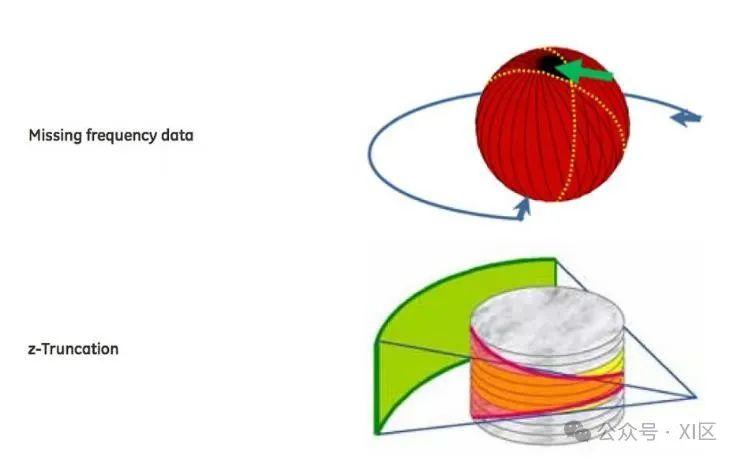

1)锥形束

从x-y平面拓展到CT的整个扫描野,可以类比的是,Z轴上的采样也是一样的不绝对均匀的。实际上的采样视野是一个球形。而且,这个球形内部的每一个像素也并非是均匀采样。

2)线束展平与插值算法

上文提到的采样频率却失可以用以下示意图表示:可以明显看到,中心的像素被采样的频率远高于边缘的像素。

换句话说,如果从时间函数的角度来观察,中心像素的正弦曲线密度一定是大于边缘像素的。

因此,出于算法数据均一性的要求,一般做法 会对边缘像素的正弦曲线进行插值处理。那么,这样插值的做法是合理的吗?可以从两个角度来来说明:

一是对于FFT算法来说,改变正弦曲线的尺度和频率,并不会改变DFT之后的特征。

二是插值的行为,效果上是将CT几何的锥形束进行了展平,回到了理想线性CT系统(“Idealized Linear CT Systems”)的设计要求。

c)单能量

1)物理值定义

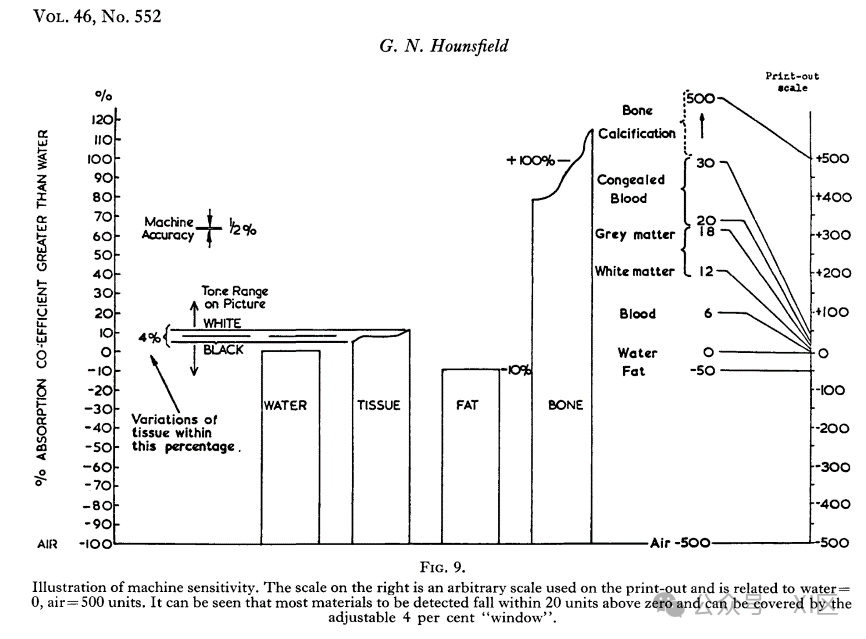

Water set to a value of 0 Hounsfield Units (HU) and air set to −1000 HU. Generally, physicians know the expected HU for a given tissue at a given kV and can therefore use an average HU measurement to understand the extent of disease.

1973年,豪斯费尔德用水和空气在CT图像上为人体刻下标度,半个世纪以来,人类都在依靠经验用数千个灰阶量化人体组织。但是CT值物理上的定义值其实是一个给定电压下的(通常为120kvp)平均数值。显而易见,在现代商业CT的kvp范围内(60kvp-150kvp)是影响CT值的一个重要因素,无论哪个kvp球管产生的X射线都会存在以下的光子能量(kev)特征:

我们无法保证穿透扫描物的光子能量都是单一的kev。这对CT值影响最重要的一个因素就是absorption coefficient(吸收系数/衰减系数),因为,对射线衰减路径上的重要理论假设就是以单能(单kev)X射线为基础的。

因此常规的CT值在kev能级层面是平均的数值。

2)mono HU

为了获得物理上更为纯净的CT值,早在1976年,科学家就已经给出答案:只需要同一个物体的独立两组不同kvp下的数据集(A1,A2),便可以分解出S1和S2 的单能量数据集monoenergetic

The spectra S, and S, may be formed in many ways. They could be monoenergetic radiation produced by two different isotope sources.[ix]

显然,Monoenergetic是物理学上更为纯净的CT值,monoenergetic能带来显而易见的优势:

一篇来自2012年的综述显示,Matsuda在单源瞬切能谱平台上利用椭圆形体模研究CT值的稳定性,发现65keV单能量图像的CT值稳定性最好,和体模的形状无关。

On a phantom study using a rsDECT scanner, Matsuda et al. found that attenuation measurements in HU on mono-energetic 65 keV images provided consistent values regardless of phantom shape, whereas conventional MDCT produced a statistically significant difference in HU measured in the center and periphery of an elliptical phantom.[x]

而来自最新2023年的siemens healthineers 光子计数CT的成果,显示了纯净的CT值在鉴别人体内组织的代际优越性。

在物理上获得接近纯净的CT值并没有结束,CT值在硬件层面还会受到CT几何结构和探测器性能的影响。

d)散射

1)滤线栅形状与病人位置的影响/Impacts of Bowtie Filter and Patient Position

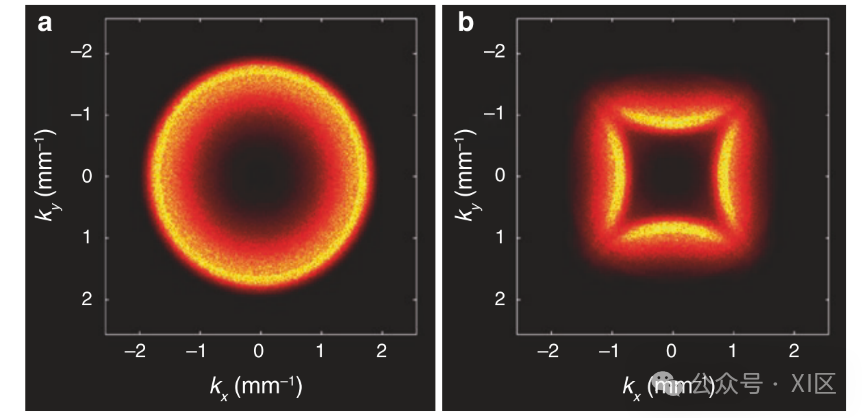

蝴蝶型滤线栅和空间位置对二维CT NPS(噪声功率谱,参阅下文)的影响。在四个位置实验测量诊断MDCT系统的NPS: a区是位于扫描仪等心处直径39 cm的圆柱体中心的5 × 5 cm2区域。在同一物体中,B区比A区高13cm。区域C是垂直离心物体中的居中区域;区域D是横向离心物体中的居中区域。对于每个区域,分别使用两个不同的领结滤波器测量二维NPS:分别用于模拟成人和儿童的衰减。

令人惊讶(或不令人惊讶)的是,现代MDCT系统中常用的蝴蝶型滤线栅对CT噪声性能有相当大的影响。如上图所示,根据蝴蝶型滤线栅的大小、物体的位置以及在图像物体中的位置,二维NPS的地形可能会偏离众所周知的“s”对称,呈现出“p”对称,甚至是看起来像三叶草叶子的“d”对称。

上图为了进行噪声分析,引入了具有负衰减系数的虚拟物体,当蝴蝶型滤线栅的CT系统对患者进行成像时,可以认为该系统为无领结系统,即对虚拟“阴性”物体和患者的组合进行成像。由于虚拟物体具有负衰减系数,因此由于正衰减和负衰减的抵消,合成物体的中心区域为空。如图(b)所示,在复合物体的外围区域拦截的x射线可能具有强烈依赖于θ的放射路径长度。在这种特殊情况下,路径长度在θ = 0和90°处达到最小值,并表现出“d”对称。(c)该区域的放射路径长度随θ的函数图。

2)混合能量射线与能量积分探测器/Impacts of Polychromatic Source and Energy-Integrating Detector

与“理想线性CT系统”一节中使用的理想光子计数和单能CT系统不同,大多数现实CT系统使用能量积分探测器和混合能量x射线源。

3)离散采样的影响/Impacts of Discrete Sampling

在“理想线性CT系统”一节中对理想CT系统的讨论没有考虑离散采样的影响。在现实的CT系统中,采样操作存在于成像链的多个阶段,包括沿离散检测器元素引入的ρ采样,沿有限检测器读出率引入的θ采样,以及沿重构CT图像的离散表示引入的(x,y)采样。以(x,y)域的采样为例,由于获得的投影数据是离散的数据数组而不是连续的R(ρ,θ)函数,并且待重构的CT图像是离散的数据点网格而不是连续的函数f(x,y),因此反投影过程通常涉及数据插值过程。如果反投影是像素驱动的,则插值可以用滤波后的投影数据与插值核gint (ρ)的一维卷积来描述;如果反向投影是射线驱动的,则插值可以用f(x,y)与2D核函数gint(x,y)的二维卷积来描述。

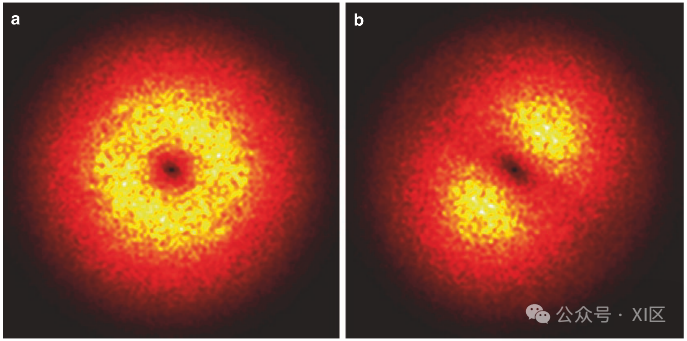

位于诊断MDCT系统(GE Discovery CT750 HD)等中心的圆柱形均匀物体的二维CT NPS。选择系统提供的高清边缘增强重建核(HD Edge)进行图像重建。(a)中的NPS使用重建像素尺寸(Δx × Δy)为0.2 × 0.2 mm的图像进行测量。(b)中的NPS使用重构像素尺寸为0.4 × 0.4 mm的图像进行测量, Δx越大,噪声混叠越强,导致(b)中的NPS不再是旋转不变量)。

4)其他考虑/Other Considerations

在现实的CT探测器系统中,二次量子的随机空间扩散、光电二极管的有限尺寸、检测器滞后、残余散射信号通过抗散射网格以及低信号校正算法往往会在ρ(路径)和θ(角度)方向上引入一定的噪声,破坏了理想CT的白噪声假设。

在实验系统的等中心放置一个圆柱形和均匀物体的二维CT NPS。(a) θ(角度)等角加权重构图像的NPS。(b) ρ(路径) Parker加权重建图像的NPS。(Figure courtesy of Dr. John Hayes)

5)现实CT系统的空间分辨率特性/Spatial Resolution

理想CT系统的空间分辨率模型假设了一组笔形束源和无空间分辨率损失的理想CT系统。在现实系统中,由于焦斑尺寸有限,探测器孔径有限,闪烁体中x射线主光子和次光子的随机扩散,CT的系统空间分辨率会极大受限。详细说明请参阅上文空间分辨率。

GE Discovery CT750 HD实时MDCT诊断系统中CT MTF的位置和方向依赖性(a)在等心处(0 cm)和离等心处(16 cm)测得的二维MTF沿径向和切向线形。(b, c)等心处和离等心16 cm处二维MTF的比较。相对于离心MTF,等向MTF具有更强的各向同性,离心MTF在切片向上的分辨率损失比径向上的分辨率损失要大得多。(d, e)两个位置的骨折模型CT样例图像。

e)FBP

1)硬件的平衡

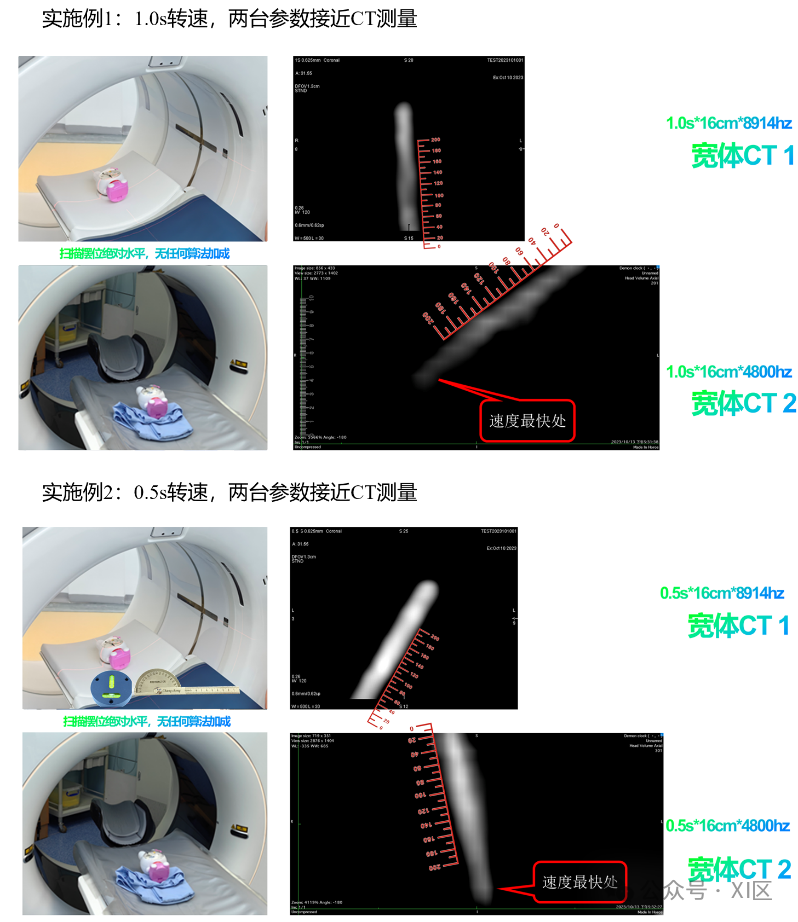

早期的CT采用平行束采集,基于Allen cormack1963年实现的反投影算法,实现了0-π数据的利用重建,即使近代采用了更快速的滑环螺旋采集和radon变换(雷登变换),CT的有效几何采集依旧限于0-π,即半圈采集范围。这也是CT时间分辨率的理论基础,即目前厂家宣称CT时间分辨率的一个标准即为CT机架的转速/2。

探测器延迟(detector lag),FBP的算法基础是以CT采集到的数据是连续的为基础的,但是实际上任何电路和电子元器件都有其工作周期,都需要服从采样定理(采样定理是E.T.Whittaker(1915)、Kotelnikov(1933)、Shannon(1948)提出的,在数字信号处理领域中,采样定理是连续时间信号(通常称为“模拟信号”)和离散时间信号(通常称为“数字信号”)之间的基本桥梁。该定理说明采样频率与信号频谱之间的关系,是连续信号离散化的基本依据。它为采样率建立了一个足够的条件,该采样率允许离散采样序列从有限带宽的连续时间信号中捕获所有信息)。因此即使是相同转速相同探测器宽度的螺旋CT时间分辨率也是有差异的。如下:

过快的转速导致数据采集不足,会让图像出现更多的artifacts(伪影),同时,探测器的性能如果过于落后,也出造成图像出现azimuthal blurring(模糊伪影)。如下图:

当然,现代CT在进行动态扫描的过程中,操作经验丰富的临床应用从业人员,应该都会知道,每台CT都有一些固定限制,如SFOV,扫描时间,扫描间隔,kvp等等因素。这样说明动态CT扫描是一个复杂的过程,尽管厂家工程师和科学家把一些复杂细节隐藏起来,但是要理解影像数据应用的第二个范式阶段,了解以上信息是必要的。

2)reconstruction kernels 算法的取舍

另外一个间接影响CT的因素就是reconstruction kernels,不同的reconstruction kernels对应不同的噪声水平,这是CT成像图像空间最大的挑战之一。

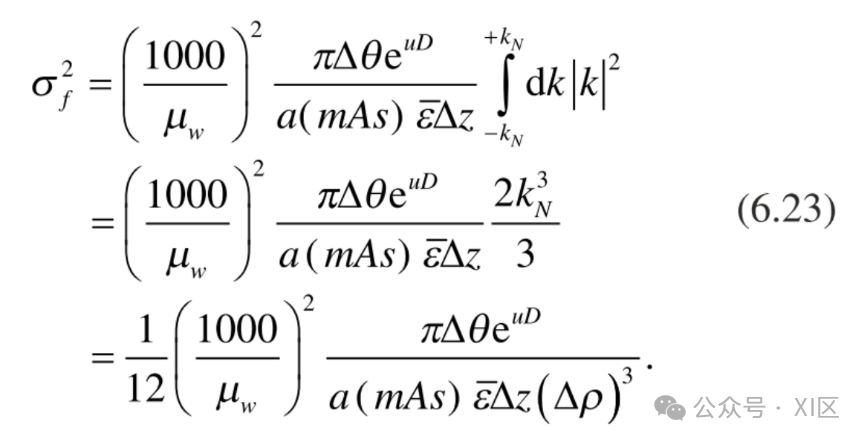

CT noise variance that corresponds to this window function is given by which is approximately 20% of the CT noise variance given by the Ram-Lak kernel in Eq. (6.23). Therefore, compared with the Ram-Lak kernel, the low-pass cosine kernel can effectively reduce CT noise magnitude. Meanwhile, for both reconstruction kernels, the CT noise variance is inversely proportional to the cube of Δρ (in-plane detector pixel size). In summary of theoretical analysis on CT noise variance, it is related to the following CT system parameters:

包含但不限于Ram-Lak kernel(斜坡滤波器); low-pass cosine kernel(低通余弦滤波器);Shepp-Logan头模型滤波器等因素作用于window function(窗函数)从而改变图像上的CT值分布,即噪声水平,还存在一些相关的因素:

卷积核/Reconstruction kernel

毫安秒/Inversely proportional to mAs

层厚/Inversely proportional to detector height Δz

探测器像素尺寸/Inversely proportional to cube of detector width Δρ

探测器系数效率/Inversely proportional to detector absorption efficiency e

CT孔径/Proportional to the exponential of patient radiological path length exp.(μD) (examples can be found in reference)

f)不可消除的噪声与无法定义的不确定性

1)电子噪声与量子噪声

CT在数学上的噪声存在于两个过程如上图。

其中forward投射过程中,伴随的电子噪声和量子噪声是无法消除的。

2)信息学不确定性

在考虑到CT的前沿技术的时候,我们应该首先把CT看作一种人类设计用于人体透视的观测系统。正与上文提到的无限复归链,CT系统从扫描到最终图像会经历一系列软硬件观测系统的转换。在最终看到的图像中,系统的不确定性并不会被消除,那么,我们看到的图像是真实的吗? 这个问题很难回答,因为行业内的从业人员绝大部分都存在一个基本的认知偏差,即当然的认为最早应用的一些技术概念是这个领域的“金标准”。例如,我们经常会听到所谓FBP就是CT成像的原始的,最纯净的,绝对真实的“金标准图像”。

实际上,这个说法是经不住推敲的,本书第一章内容,我们知道FBP算法是经过F(filter)滤波和BP(backprojection)插值平行反投影处理的,这两个步骤显然删除和增加了一些数值;另外,由于FBP是行业公开的算法,不同CT供应商采用FBP算法图像的时候,行业从业经验稍长的都会有这样的经历:即同一个病人由于各种原因(符合医学伦理原则),针对同一个病变,在不同的两个供应商CT上进行了扫描,结果是一个显示了病变,一个未显示(或显示不明)病变。

显然,目前CT领域事实上并不存在一个绝对的“金标准”。回到问题,是否存在理论上的100%还原人体的理想CT?实际上在本书第一章有所描述,需要在工程上实现理想线性CT模型/Idealized Linear CT Systems并克服探测器噪声/Noise Properties of Raw Detector Outputs;同时在重建算法上消除投射集噪声/Noise Properties of Post-log Projection Data和图像阈噪声/Noise Properties of CT Images。这是一个理想目标,也就是说现实是无法实现的。就像冻结所有分子原子运动的绝对零度,我们知道,但是触碰不到。如果用通讯系统的角度来看待CT成像系统,那么单次扫描实现W’/W的香农极限[xi]传递是不可能的。

工程学上,所有的扫描仪不过是对真实世界的粗糙建模,但是:“所有的模型都是错误的,但有些是有用的。All models are wrong, but some are usefull[xii]”。在此时此刻,莫名生出一种只缘身在此山中的感觉。任何知识信息都是有时效性的。

g)贝叶斯派和频率派

对于不确定性的度量统计学里至少有两种不同的考虑方式,这导致了两种不同类型的推理/决策方法,我们称之为频率论(frequentist)和贝叶斯方法(Bayesian methods)。

这是两种认识世界的视角,我意识到西方科学的成功并非全部建立在精确的概念之上,或者说,世界的底层是建立在不可消除的不确定性之上的。

同样的两种方式,其实也体现在CT重建图像的算法之中:深度学习和传统方法自2018年前后。就有相当多的理论分级。如深度学习为全局频率派方法,迭代方法为局部贝叶斯派方法(已知的联影 佳能采用了迭代数据集的都属于此)。

深度学习为无先验模型的数据驱动型方法;迭代为部分先验的模型驱动型方法(已知的联影、佳能采用了迭代数据集的都属于此)。

以上是基于实现方法对目前市售CT产品算法的一个分级,虽然市场概念上有所相似,但是其具体路径存在差异,核心点就在于是否能实现频率派方法(或称数据驱动型)与贝叶斯派方法(或称模型驱动型)的分离,可以看到传统的方法全部属于模型驱动的贝叶斯派方法,除去TrueFidelity之外,号称采用深度学习手段的方法无一例外都是采用了频率派与贝叶斯派混合的手段,其好坏目前难以评价。我们参考一下Jonas Adler的观点:

目前主要的几种噪声范数形式:

几种重建类型,FBP;TV为传统模型驱动的混合方法;deep learning方法

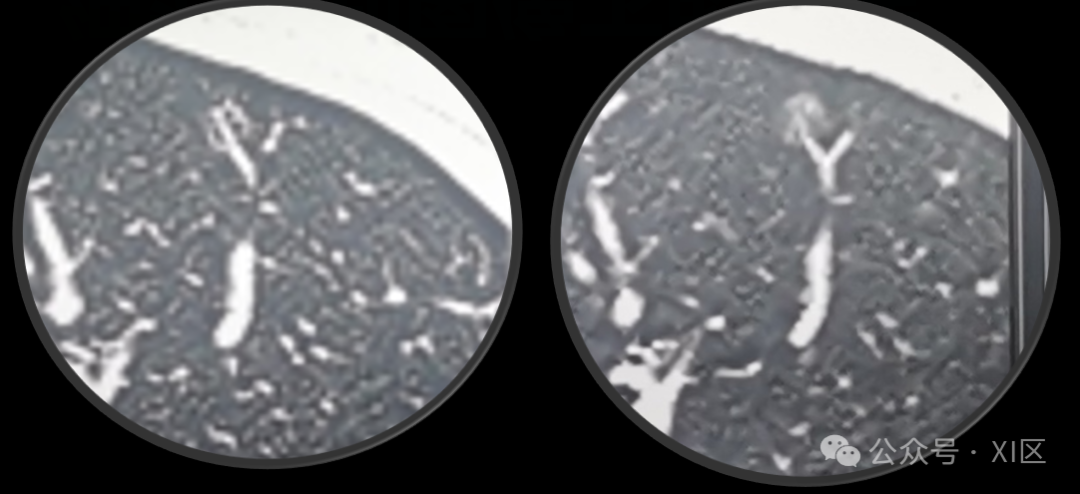

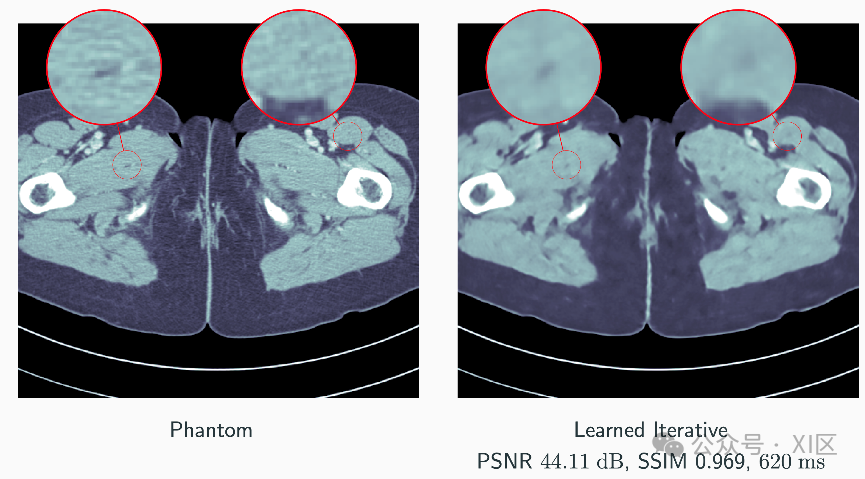

体模与FBP算法对比:

体模与TV混合模型驱动混合方法对比:

体模与深度学习方法对比:

体模与深度学习迭代方法混合方法对比:

小结:

• Very large quantitative improvement/巨大的图像质量提升

• Noticeable visual improvement/肉眼可见的提升

• Very short run-times/很短的运行时间

• Looks oversmoothed/过渡柔和

采用频率派和贝叶斯派混合方法的手段,需要极其注意模型的过度柔和问题。具体原因本文不作展开,可以参考Jonas Adler 关于inversion problem的论文。

三、从可计算性看世界的运行范式?

a)他们在创造大脑

当世界正发生人工智能革命的时候,会有相当一部分声音:人工智能不直接参与生产,与之前的互联网泡沫本质是一样的。殊不知,一切斗争都是为了争取统一的斗争,一切问题,也是关于决策的问题。偶然,听到一句话,深刻说明了人工智能的价值:他们在创造大脑。

足够强大,甚至超越人类的智能将会挑战一切规则。

1)Alpha go/人类规则,神之一手

围棋,是人类创造的游戏,也是人类制造的规则。每一步落子都超过200种可能,小小一个棋盘上的可能性总数超越了宇宙中原子的数量。DeepMind 创造的Alpha Go看似荒谬但却影响深远的落子,看似毫无价值却对胜负有绝对影响的选择,数千年来,人类苦苦追求的必胜之法,神之一手。从来没有任何人能想象,终极答案竟然是全局0.5子的胜率。

2)Alpha fold/自然规则,预测中心法则

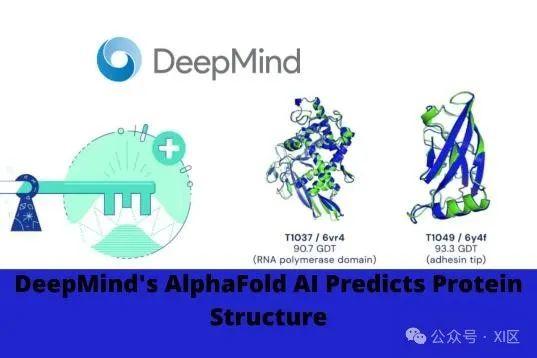

DeepMind在生命科学领域一鸣惊人——它的最新版AlphaFold在两年一度的蛋白质预测大赛CASP(蛋白质结构预测关键评估)中所向披靡。AlphaFold的一些预测结果与准确度很高的实验模型相当,CASP比赛中的一些结构曾让AlphaFold花了好几天的时间进行计算,但最新的AlphaFold只要几分钟到几小时就能完成计算。

效率的提升让DeepMind团队可以预测由人类基因组编码和20个模式生物的几乎所有已知蛋白。这些结构数据储存在英国EMBL-EBI(欧洲分子生物学实验室欧洲生物信息研究所)托管的一个数据库中。AlphaFold预测的结构覆盖了98.5%的已知人类蛋白和其他生物的同比例蛋白。

3)ChatGPT/超级对齐

叹息之墙:是希腊神话中分界极乐净土和冥界的一块墙壁。是拥有无限宽度和厚度的不可跨越的屏障,当GPT内部的token Embedding规模越来越大,你能想到的,不能想到的,现在,过去,未来。人类依靠符号主义线性连接的所有可能性都藏在这个token Embedding内部,这何尝不是人类无法跨越的叹息之墙。

ChatGPT的快速进展,也提示了一件事,在更深层的结构中,所有表达体系都是统一的,都可以被深度学习超级对齐,成为可以相互转译的描述系统。

1.等价转译

一个事物可以用英语描述就一定能用中文或其他任何描述系统说明,历史上有大量大量的资料或个人都提到了这个观点。

也即说明,在无限样本的群体中,符合原理的真理会一次又一次的被唤醒被重视,从而影响世界。这让我想起一个西方故事。

2.通天塔的隐喻

“巴别塔”是《圣经·旧约·创世记》第11章故事中人们建造的塔。根据篇章记载,当时人类联合起来兴建希望能通往天堂的高塔;为了阻止人类的计划,上帝让人类说不同的语言,使人类相互之间不能沟通,计划因此失败,人类自此各散东西。此事件,为世上出现不同语言和种族提供解释。

ChatGPT的兴起,也许是人类重新建造巴别塔的契机!

b)哲学之问-计算为什么能取得如此成功?

虽然工程上,深度学习取得了巨大成功,但是没有回答一个问题,因为迄今为止,深度学习的原理是无人能解释的。亦或这个问题可以另一种问法,计算为什么能取得如此成功?

1)休谟-怀疑主义

历史学家一般将休谟的哲学归类为彻底的怀疑主义,历史上著名的“休谟问题”便是怀疑论的经典问题。休谟问题分为因果问题和归纳问题,前者质疑了作为科学基础的因果关系理论,后者质疑了归纳推理。

休谟主张,大部分人都确信只要一件事物伴随着另一件事物而来,两件事物之间必然存在着一种关系,使得后者伴随前者出现。尤其是当两件事物前后发生的频次足够多时,人们对二者间存在关系的信念会增强,甚至认为二者存在必然关联。

为什么在这里提及休谟?因为这与我们每天的工作息息相关,例如:我们CTA图像上看到的冠脉的粥样硬化(或没看到),随后在侵入性的DSA检查中(或者死亡报告的尸检)中看到(或没看到)粥样硬化。这就使得很多从业者建立了两种现象的关联关系。但是现实是复杂的,CTA和DSA以及病人之间的关联性并不是观察经验决定的,各个厂家设备,操作方式习惯等一系列因素。简而言之,人类观察到事物之间的可能关联性是不可靠的,因为这取决于当前认知水平。而,通用计算,把认知水平的差异极大的缩小了,即操作者或观察者不需要考虑到过程中复杂的物理算法变量,直接依靠自己的主管观察,即可以高成功率的结果获得DICOM图像与真实人体的关联性(非因果性)。

2)康德-因果关系是否具有普遍性和客观性?

作为英国经验论派的代表,休谟否定其必然性。在他看来,一切现实事物的关系都不具有必然性,包括最为重要的因果关系。我们常常观察B事物在A事物之后,久而久之,就以为B事物必然伴随A事物。这不过是种蹩脚的归纳法使然,难道说,以前的人们看到的天鹅都是白的,就能断定天下的天鹅一般白吗?

因此,以归纳法而认识到的关系只具有或然性。因果关系是信念的产物。至少在事实类上。

唯一的意外是:休谟对于数学和逻辑倒没加质疑。

康德指出,数学判断是种综合判断,它必须借助于直观而得到。即验证不需要经过现象A,B的先后关系来归纳。而是天然直观获得的。

3)牛顿,爱因斯坦,冯诺依曼-数理逻辑的里程碑!

尽管数理逻辑并非艾萨克牛顿爵士创立,但是其成就绝对彪炳史册。其计算的数据来源于另一位先驱经年累月的观测。

布拉赫.第谷为高精度的天文数据观测记录作出了杰出贡献,他的工作协助了开普勒提出了行星三定律。最终,在一个炎热的下午,牛顿天才的创想:一切的事物的过程都可以分解为嵌套的速度变化函数,一切事物的结果都可以综合为速度变化覆盖的面积。这个规律完全打破了怀疑主义,虚无主义的论调。宇宙间确实存在着可以支配星宇的规则,这个规则可以被认识,可以被正确利用。第谷的事迹,也一直激励着我,即使不能成为最终发现规律的人,也要做好记录,为后来人打好基础。

其后,爱因斯坦以纯数理逻辑揭示了时弯曲的奥秘;冯诺依曼制造了人类第一台通用计算机,把大规模通用计算普及到世界,几乎完全改变了世界的面貌。

4)东方文化哲学-道可道,非常道。

不可否认,西方科学取得了巨大成功。难以回避的是,我们确实遭遇了一些困境。这里我想到了一句台词[xiii]:美国人天真热情,敢想敢干;日本人有归属感,有团队精神;犹太人意志坚强,心齐如一;意大利人重亲情为家族;这些优点我们中国人都有。

精确概念并非西方科学成功的核心原因,因为存在着不可消除的不确定性。我们也有着数千年的辩证思维:反者道之动。一切事物都会走向他的反面;亦有圣贤之道,吾性具足,惟此心光明,致良知二字。更有宇宙即我心,我心即宇宙。细微至发梢,宏大至天地[xiv]的气吞山河。

拥有足够多的历史,为何通用计算的萌芽没有出现在我们的文化里?

我之见解为:西方文艺复兴工业革命,工人运动已经数百年。而在古老的东方,第一次把人民性概念搬进宪法也不过百年。我们不过是在发展的阶段之中,有理由相信,在无限样本的宇宙中,采取频率派路线的组织,会一次又一次涌现出最科学合理的方向。

c)可计算的宇宙

上一节试图从前人哲学的成就中得到答案,即面对如此不精确的概念和不确定性,计算,是否是一种可靠可喜的认识和改造世界的手段,这是数字孪生得以获得光明未来的前提和保证。我们可以看一些严谨的论述。

1)什么是计算?

Allen Turing被誉为计算机原理,人工智能之父。数理逻辑是否可以描述所有事物?

是的!

可计算性理论(Computability theory)作为计算理论的一个分支,研究在不同的计算模型下哪些算法问题能够被解决。相对应的,计算理论的另一块主要内容,计算复杂性理论考虑一个问题怎样才能被有效的解决。可计算理论的研究对象有三个 :

(1) 判定问题:事物是否可用数理逻辑判定?(即计算机内部的变量类型和布尔逻辑描述)

(2) 可计算函数:函数有解

(3) 计算复杂性:函数的计算时间为有限长度。

2)哥德尔不完备定理

但是!但是不能完整描述,每个数学系统都存在一些语句永远无法被证明。

一致的,不会导致矛盾,同时也是完备的所有数学真理的基础并不存在。

计算科学中的停机问题即是明证:

lP有解,但是不可计算,因为计算时间无限长。

lP可以在有限的时间内计算,但是无解。

两种情形都是计算科学不能承受之重。

3)奥卡姆剃刀

奥卡姆剃刀定律(Occam's Razor, Ockham's Razor)又称“奥康的剃刀”,原理称为“如无必要,勿增实体”,即“简单有效原理”。通用计算是目前最简单有效的认识世界的手段。

4)可计算性与医学影像的未来

当前,相当的行业从业者都判断,大型影像设备的增量空间趋于平缓,新的行业转换周期就在眼前。

自2015年,各路资本和团队相继入局。

类似于移动互联网时代,各个团队急于跑马圈地。却只关注了上层应用,尚未见任何一家公司或团队说明过,为什么要引入深度学习,通用计算的方法是否足以重塑医学影像行业!可想而知,浪潮褪去,必定一地鸡毛。

仅就本文而言,digital twin(数字孪生)概念是可行的链接本行业过去海量数据和未来巨大可能的最佳选择。本文简单论述了以CT为例的现状,尽管有着硬件和标准和执行性上的巨大挑战,但是。基于可计算性原理的GE医疗和西门子医疗在设备的一致性上取得了可信的成就,但是这依旧不足以打开未来世界的大门。

尽管市面上存在有医疗元宇宙的概念,但是,回顾第一章,我们需要的不是一个静态的数字玩偶,我们要打造的是一个具备自主能力的数字生命,她储存着人类所有的结构性;神经体液调节;免疫系统疾病;她通过环境感知和文本分析可以与患者共情。也许她会证明,可计算性是宇宙的本质,理性和人性就是可计算性的阳面;而自由意志和艺术的涌现就在哥德尔不完备的阴影之中。

医疗行业的ChatGPT时刻远没有带来,但是可以期待的是在客观条件上我们已经具备。

5)神女应无恙,当惊天下殊

也许我们期待的世界需要在生产力发展到极致以后才会出现,那不知道需要有多久,但是应该保持足够信心,长城内外,江河上下。曾为天人想象的更立西江石壁,截断巫山云雨,高峡出平湖已经变为现实,这无疑是对我们的巨大激励。

如果,世界的本质真的可计算的[xv](自2023年6月萌生此文想法,这里可以参考Stephen Wolfram的另一种视角)。

在可计算的宇宙中不存在任何特权样本,采用贝叶斯视角的精英主义大概率会行行失故路,而全局频率视角的群体主义任道或能通。